专门适配轻小说/Galgame的开源日中翻译大语言模型,支持本地部署和隐私保护,在ACGN内容翻译领域表现优秀

一、工具概览

基本信息:

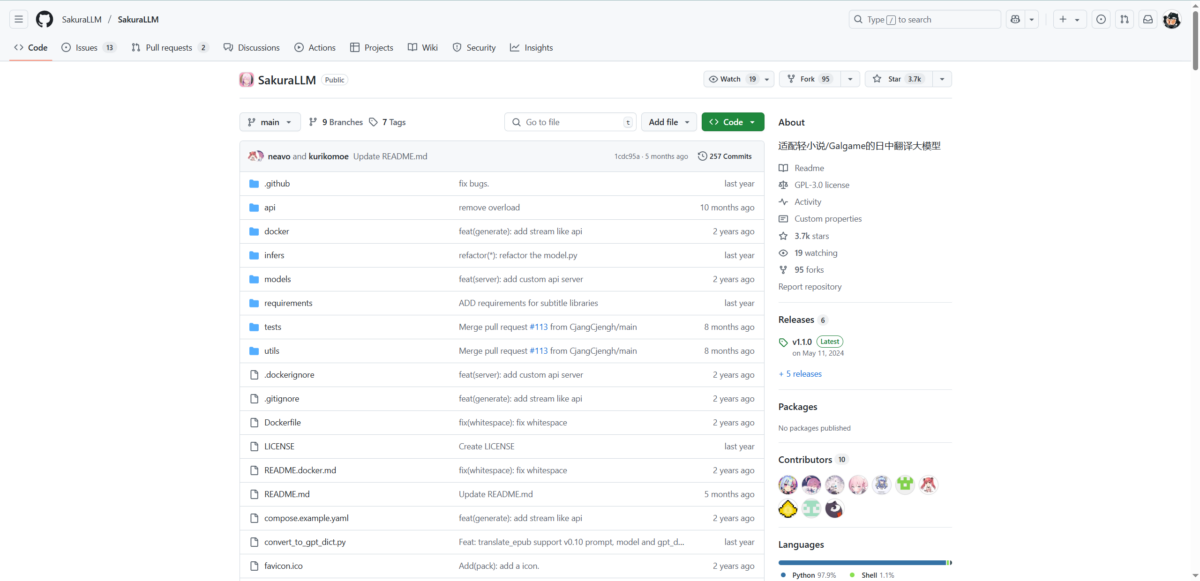

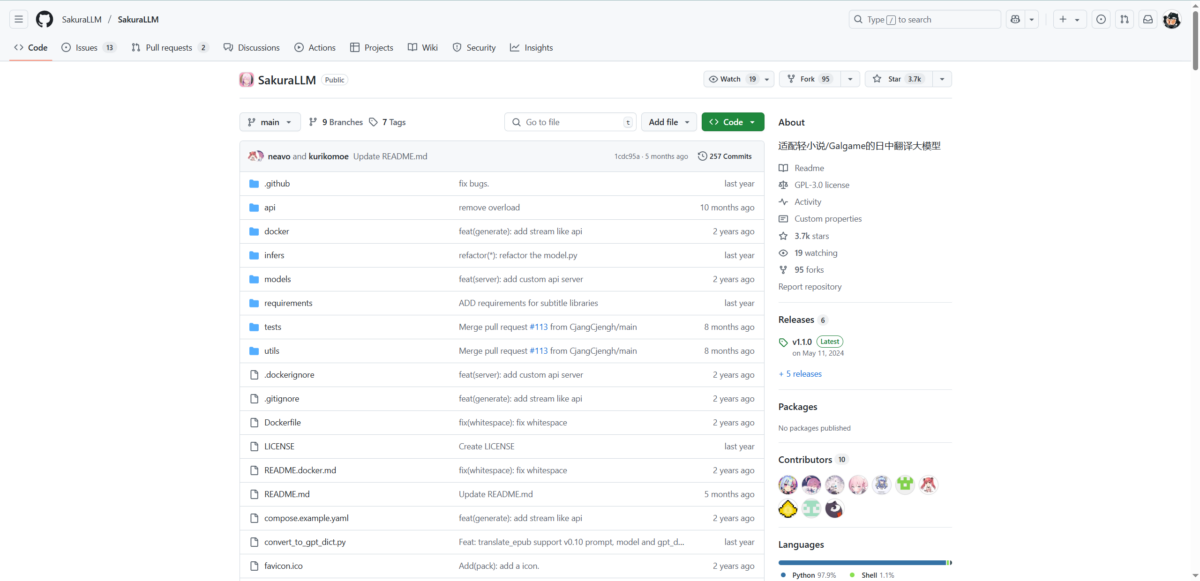

- 工具名称:SakuraLLM

- 开发团队:SakuraLLM开源社区(主要贡献者:SakuraUmi、xd2333等)

- 发布时间:2023年8月首次发布,持续更新至今

- 定位:专门适配轻小说/Galgame的日中翻译大语言模型

- 技术架构:基于Baichuan2、Qwen等开源大模型,通过继续预训练与微调优化

SakuraLLM是一款专为ACGN(动漫、漫画、游戏、小说)内容翻译而生的开源大语言模型。基于一系列开源大模型构建,在通用日文语料与轻小说/Galgame等领域的中日语料上进行继续预训练与微调,旨在提供开源可控可离线自部署的、ACGN风格的日中翻译模型。该项目的核心特点是完全离线部署,保护用户隐私的同时提供专业化的翻译服务。

从技术发展路径来看,SakuraLLM经历了多个重要版本迭代。从最初的sakura-13b-2epoch-260k-0826-v0.1到最新的v1.0版本,项目不断改进翻译质量和技术架构。最新版本基于Qwen2.5底模构建,提供了1.5B、7B、14B等多种参数规模的模型,满足不同硬件配置用户的需求。

值得注意的是,目前Sakura发布的所有模型均采用CC BY-NC-SA 4.0协议,Sakura所有模型与其衍生模型均禁止任何形式的商用,这明确了其学术研究和个人使用的定位。

二、核心功能解析

主要功能模块

翻译核心引擎:SakuraLLM的核心是针对日中翻译特别优化的语言模型。目前仍为实验版本,翻译质量在文风与流畅度上强于GPT-3.5,但词汇量逊于GPT-3.5。该模型特别强化了对ACGN内容的理解能力,能够准确把握轻小说和游戏中的独特文风和语境。

术语表支持:最新版本引入了GPT字典功能,支持术语表(GPT字典),以保持专有名词和人称的一致性。这项功能对于翻译包含大量专有名词的ACGN内容尤为重要,能够确保角色名称、地名等关键词汇的翻译一致性。

多样化部署方案:SakuraLLM支持多种推理后端,包括transformers、llama.cpp、vllm等,Sakura API已经支持OpenAI格式,现在可以通过OpenAI库或者OpenAI API Reference上的请求形式与Server交互。这种兼容性设计大大降低了集成门槛。

性能表现和局限性

在性能方面,SakuraLLM在特定领域表现出色。根据项目文档显示,模型在处理轻小说和Galgame文本时,能够较好地保持原文的文学风格和情感表达。主要改进:改善翻译质量,提高翻译准确率,尤其是人称的准确率;提高部分简单控制符的保留能力,尤其是单行内存在n的情况下保留n的能力。

然而,模型也存在明显局限性。开发团队坦诚指出了当前版本的问题:对于模型翻译的人称代词问题(错用,乱加,主宾混淆,男女不分等)和上下文理解问题,如果有好的想法或建议,欢迎提issue。这表明模型在复杂语境处理方面仍有改进空间。

使用门槛和学习成本

SakuraLLM的部署相对复杂,需要一定的技术背景。模型显存大小:sakura-14b-qwen2.5-v1.0-iq4xs.gguf需要10GB显存,sakura-14b-qwen2.5-v1.0-q6k.gguf需要12GB显存。对于普通用户而言,硬件要求可能是一个门槛。

不过,社区提供了多种简化部署的方案。Sakura Launcher GUI支持NVIDIA独立显卡,部分AMD独立显卡和一部分核显的一键安装与启动;OneClickLLAMA一键包可以支持各种不同显存挡位的显卡,这些工具大大降低了使用门槛。

三、商业模式与定价

开源免费策略

SakuraLLM采用完全开源免费的模式。所有模型和代码都在GitHub和Hugging Face平台免费提供下载。这种策略的优势在于:

- 零成本使用:用户无需支付任何费用即可获得专业级翻译服务

- 数据隐私保护:本地部署确保翻译内容不会泄露给第三方

- 可定制性强:开源特性允许用户根据需求进行个性化调整

许可协议限制

值得注意的是,v0.8版本模型的使用须遵守Apache 2.0、《Baichuan 2 模型社区许可协议》和CC BY-NC-SA 4.0协议;v0.9版本模型的使用须遵守Qwen模型许可协议和CC BY-NC-SA 4.0协议;v1.0版本模型的使用须遵守CC BY-NC-SA 4.0协议。

CC BY-NC-SA 4.0协议的关键限制包括:

- 禁止商业用途

- 要求署名

- 相同协议传播衍生作品

- 允许学术研究和个人使用

成本效益分析

与商业翻译服务相比,SakuraLLM在成本方面具有显著优势:

传统方案成本:

- 人工翻译:每千字50-200元

- 在线API服务:如GPT-4 API每千token约0.03-0.06美元

- 商业翻译软件:年费数百至数千元

SakuraLLM成本:

- 硬件投入:一次性购买显卡(10GB以上显存)

- 电力消耗:推理时功耗约200-400W

- 维护成本:几乎为零

对于有长期翻译需求的用户,SakuraLLM的投资回报期通常在3-6个月内。

四、适用场景与目标用户

最佳使用场景

轻小说翻译:这是SakuraLLM的核心应用场景。轻小说机翻机器人已接入Sakura模型(v0.8-4bit),站内有大量模型翻译结果可供参考。对于想要阅读日本原版轻小说的读者,SakuraLLM提供了质量相对较高的机翻选择。

Galgame实时翻译:LunaTranslator已经支持Sakura API,可以通过本地部署API后端,并在LunaTranslator中配置Sakura API来使用Sakura模型进行Galgame实时翻译。这为游戏玩家提供了便捷的实时翻译解决方案。

汉化补丁制作:GalTransl已经支持Sakura API,可以通过本地部署API后端,在GalTransl中配置使用Sakura模型来翻译Galgame,制作内嵌式翻译补丁。专业汉化组可以利用这一功能提高工作效率。

适用人群画像

ACGN爱好者:轻小说与Galgame爱好者: 对于那些渴望跨越语言障碍,直接阅读原汁原味的日本作品的读者与玩家,SakuraLLM提供了近乎实时的翻译体验。这类用户通常具备一定的技术能力,愿意投入时间学习部署流程。

汉化工作者:游戏开发与本地化团队: 在游戏的国际发行过程中,快速而准确的翻译工作是至关重要的。SakuraLLM能够加速这一过程,降低人工成本,同时保持翻译的品质。

技术研究者:对自然语言处理、机器翻译技术感兴趣的研究人员,可以利用SakuraLLM进行学术研究和技术探索。

不适合的情况

商业用途:由于CC BY-NC-SA 4.0协议限制,SakuraLLM不能用于任何商业目的。

对翻译质量要求极高的场景:虽然SakuraLLM在ACGN领域表现不错,但对于专业文档、法律文件等要求极高准确性的内容,仍建议使用人工翻译。

硬件资源不足的用户:模型运行需要较高的硬件配置,对于只有集成显卡或低配置设备的用户可能无法正常使用。

五、市场地位与竞品对比

主要竞品分析

通用翻译服务对比:

与Google Translate、DeepL等主流翻译服务相比,SakuraLLM的差异化优势明显。谷歌翻译 vs ChatGPT vs DeepL:机器翻译终极对决的测试中,DeepL的新一代大型语言模型翻译质量优于ChatGPT-4、谷歌和微软,但这些都是通用翻译服务。

SakuraLLM虽然在通用翻译任务上可能不如这些商业服务,但在ACGN内容翻译方面具有独特优势:

- 对二次元文化和语境的深度理解

- 角色对话风格的准确把握

- 专有名词和人称代词的精确处理

ACGN翻译工具对比:

在专门的ACGN翻译领域,SakuraLLM与传统机翻工具相比具有显著优势:

| 工具 | 优势 | 劣势 |

|---|---|---|

| 传统机翻(Google/百度) | 速度快,稳定 | 不理解ACGN语境,人称混乱 |

| GPT-3.5/4 | 理解能力强 | 成本高,需联网,可能被限制 |

| SakuraLLM | ACGN专业化,免费,可离线 | 需本地部署,硬件要求高 |

差异化优势

专业化定位:SakuraLLM是基于一系列开源大模型构建,在通用日文语料与轻小说/Galgame等领域的中日语料上进行继续预训练与微调的日中翻译模型。特点为开源可控可离线自部署,以及有较强的ACGN风格。

生态集成优势:SakuraLLM已经与多个专业工具深度集成:

- LunaTranslator是由开发者HIllya51发起的开源项目,专注于解决Galgame玩家及多语言场景用户的翻译需求

- GalTransl支持GPT-4/Claude/Deepseek/Sakura等大语言模型的Galgame自动化翻译解决方案

- 漫画翻译工具manga-image-translator和BallonsTranslator的支持

市场表现

从社区活跃度来看,SakuraLLM在GitHub上获得了广泛关注,相关项目仓库收到大量star和issue。新建了TG交流群,欢迎交流讨论,表明项目具有活跃的用户社区。

在实际应用方面,轻小说机翻机器人网站已接入Sakura模型,站内有大量模型翻译结果可供参考,这证明了模型的实用性和可靠性。

六、用户体验评价

界面和操作体验

SakuraLLM本身是一个模型,用户体验主要体现在集成工具中。以LunaTranslator为例,支持几乎所有能想得到的翻译引擎,包括在线翻译、传统翻译和大模型翻译,界面设计相对友好。

部署方面,项目提供了详细的文档和多种部署方案:

- Python直接部署

- Docker容器化部署

- 一键包部署方案

技术支持质量

文档完善度:项目在GitHub Wiki中提供了详细的部署教程、使用说明和FAQ。包含Python部署教程、llama.cpp一键包部署教程等多种部署方式的详细说明。

社区支持:

- GitHub Issues活跃,开发团队响应及时

- Telegram交流群提供实时讨论

- 多个第三方教程和使用经验分享

更新频率:项目保持较高的更新频率,定期发布新版本和功能改进。

安全隐私

数据安全:本地部署的特性确保了翻译内容的完全隐私保护,这对于翻译敏感或私人内容的用户尤为重要。

模型安全:所有模型都经过了负责任的AI原则审查,开发者对于滥用本模型造成的一切后果不负任何责任,体现了开发团队的谨慎态度。

使用限制:如果使用模型翻译并发布,请在最显眼的位置标注机翻!!!!!,要求用户明确标注AI翻译,体现了对内容透明度的重视。

性能稳定性

推理性能:新版本采用GQA架构,由于底模使用GQA,推理速度和显存占用显著改善,可实现更快的多线程推理。

稳定性问题:部分用户反映在长时间运行时可能出现内存泄漏或性能下降,需要定期重启服务。

兼容性:支持多种操作系统和硬件配置,但在某些特定环境下可能需要额外调试。

总结评价

SakuraLLM作为专门针对ACGN内容翻译的开源大语言模型,在特定领域展现出了显著的价值。其最大亮点在于完全免费的专业化翻译服务和强大的生态集成能力。

核心优势:

- 专业化程度高:针对轻小说和Galgame内容进行了深度优化

- 完全开源免费:为个人用户和研究者提供了低成本的专业翻译方案

- 生态系统完善:与多个专业工具深度集成,形成了完整的翻译工作流

- 隐私保护到位:本地部署确保数据安全

主要局限:

- 硬件门槛较高:需要较高配置的GPU才能流畅运行

- 商用限制:协议限制了商业应用的可能性

- 通用性不足:主要适用于ACGN内容,其他领域表现一般

- 技术门槛:部署和维护需要一定的技术能力

适用人群:

- ACGN内容爱好者

- 汉化工作者和翻译爱好者

- 自然语言处理研究者

- 注重隐私保护的用户

发展前景: 随着开源大模型技术的快速发展和社区的持续贡献,SakuraLLM有望在专业化翻译领域继续保持领先地位。特别是在中日文化交流日益频繁的背景下,这类专业化翻译工具的需求将持续增长。

推荐指数:★★★★☆

SakuraLLM在ACGN翻译这一细分领域表现优秀,对于有相关需求且具备一定技术能力的用户来说,是一个非常值得尝试的工具。虽然存在硬件要求高、部署复杂等门槛,但其专业化程度和免费开源的特性使其在该领域具有独特的竞争优势。随着社区生态的不断完善和技术的持续优化,SakuraLLM有望成为ACGN翻译领域的标杆产品。