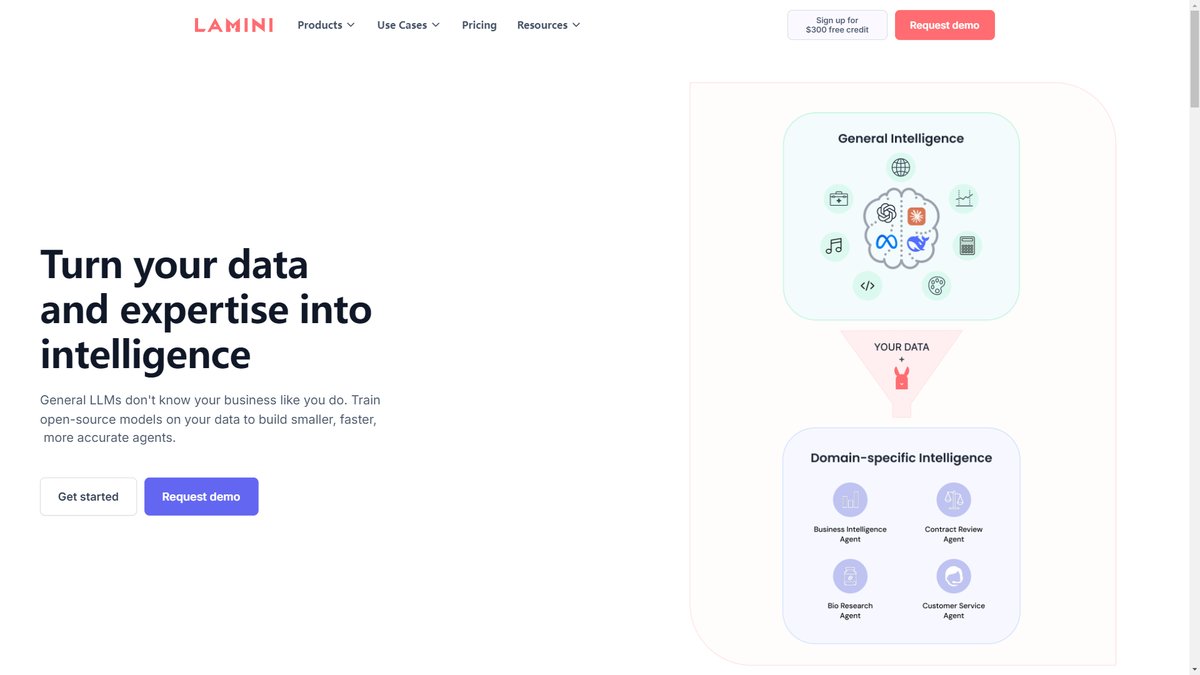

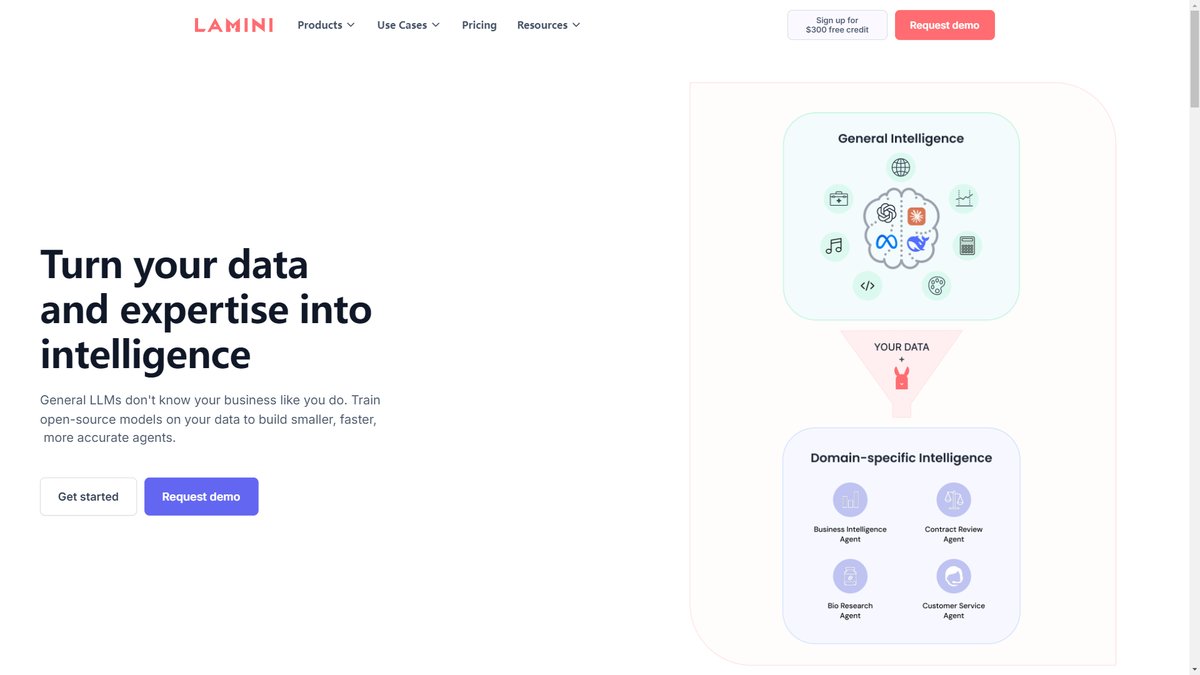

专为企业打造的LLM开发平台,通过独创Memory Tuning技术将模型准确率提升至95%,支持安全部署和私有数据训练

一、工具概览

基本信息:

- 名称: Lamini

- 开发商: PowerML Inc.(官方名称)

- 发布时间: 2022年

- 创始人: Sharon Zhou(CEO)和Greg Diamos(CTO)

- 总部: 美国加州帕洛阿尔托

- 定位: 企业级大语言模型训练与部署平台

- 融资状况: 2024年5月完成2500万美元A轮融资,累计融资2500万美元

Lamini是一个专为企业打造的大语言模型开发平台,致力于帮助企业利用私有数据构建定制化的LLM模型。该平台由两位AI领域资深专家创立:Sharon Zhou曾是斯坦福大学教授,师从著名AI学者Andrew Ng;Greg Diamos是MLCommons联合创始人,曾在英伟达CUDA团队担任软件架构师。

技术架构特点:

Lamini的核心技术优势在于其独创的"Memory Tuning"(记忆调优)技术,这是一种突破性的模型训练方法,能够让LLM在保持通用语言能力的同时,精确记忆和召回特定的事实信息。该技术通过创建数百万个专门的适配器(LoRAs),每个适配器专注于特定的知识领域,在推理时智能选择最相关的专家适配器。

平台支持多种部署环境,包括云端VPC、本地部署、甚至是完全隔离的空气隔离环境,确保企业数据的绝对安全。值得注意的是,Lamini是目前唯一一个能够在AMD GPU上高效运行LLM的平台,这得益于其与AMD的深度技术合作。

用户规模与发展状态:

自2023年4月正式发布以来,Lamini已经吸引了超过5000家企业加入等候名单。目前平台已被多家Fortune 500企业和顶级AI初创公司采用,包括AMD、iFit(NordicTrack母公司)、AngelList等知名客户,以及多个未公开的政府机构。

二、核心功能解析

主要功能模块:

-

Memory Tuning技术

- 将模型在专有数据上的准确率从通用LLM的50%提升至95%以上

- 显著减少AI幻觉现象,幻觉率降低95%

- 支持对数十亿份专有文档进行精确记忆和检索

-

多模型训练与微调

- 支持Llama 3.1、Mistral v0.3、Phi 3等主流开源模型

- 提供参数高效微调(PEFT)和LoRA技术

- 支持强化学习人类反馈(RLHF)训练

- 可在数千个GPU上并行训练,将1000小时训练时间压缩至1小时

-

智能推理引擎

- 保证100% JSON格式输出,无需额外解析器

- 推理速度比同类平台快52倍

- 支持每秒500+ QPS的嵌入向量生成

- 提供批量推理优化

-

安全部署选项

- 支持本地部署、VPC云端部署和空气隔离环境

- 多云厂商兼容(AWS、Azure、Google Cloud)

- 同时支持Nvidia和AMD GPU硬件

- 企业级安全和合规框架

性能表现和局限性:

性能优势方面,Lamini在关键指标上表现出色:准确率提升至95%、训练速度提升100倍、推理吞吐量提升52倍。其"摄影记忆"评估套件显示,在处理具体数字和事实信息时,Lamini训练的模型表现明显优于GPT-4+RAG组合。

然而,平台也存在一些局限性:免费版本的调优请求有限制;需要特定的GPU类型(Nvidia或AMD)进行部署;对于小型团队而言,企业级功能的完整使用成本较高;目前主要支持英语,多语言支持有限。

使用门槛和学习成本:

Lamini的一大优势是降低了LLM开发的技术门槛。平台提供了简洁的Python库、REST API和用户友好的界面,使得非机器学习专家的开发者也能够快速上手。核心训练流程只需几行代码即可完成:

from lamini import Lamini

llm = Lamini("meta-llama/Llama-2-7b-chat-hf")

llm.train(data_path="your_data.jsonl")

平台还提供了详尽的文档、教程视频和在线支持,由专门的AI工程师团队提供企业级技术支持。

典型使用案例展示:

- iFit案例:为600万用户生成个性化健身计划,通过Lamini训练的私有模型实现高度定制化的AI健身教练

- AMD案例:在内部Kubernetes集群中部署Lamini,基于AMD代码库训练专门的开发者任务模型

- 金融行业:训练xFinance 130亿参数模型,专门处理金融NLP任务,展现出色的行业专业性

三、商业模式与定价

定价策略:

Lamini采用灵活的按需付费模式,为不同规模的用户提供适配的定价方案:

-

免费试用

- 新用户获得300美元免费额度

- 小型LLM训练完全免费

- 支持完整功能体验

-

按需付费(On-Demand)

- 推理费用:每100万token 0.50美元(输入、输出、JSON输出统一价格)

- 调优费用:每调优步骤0.50美元(2024年更新前为1美元/步骤)

- GPU数量线性计费:使用2个GPU则费用翻倍,以此类推

-

企业级定价

- 起价99美元/月

- 可下载模型权重

- 不限制模型大小和类型

- 控制吞吐量和延迟

- 专属GPU集群选项

免费vs付费功能对比:

免费版本提供完整的模型训练体验,包括模型选择、RAG/提示调优、记忆调优、评估和推理功能,但限制在小型模型和有限的调优请求上。付费版本则解锁了大型模型训练、企业级安全部署、专属GPU资源、24/7技术支持等高级功能。

性价比评估:

相比于其他企业级AI平台,Lamini的定价具有明显优势。300美元的免费额度相当慷慨,足以支持中小型项目的初期验证。0.50美元/百万token的推理成本在行业中处于中等偏低水平,特别是考虑到其95%的准确率和guaranteed JSON输出功能。对于需要高精度、低幻觉率的企业应用,Lamini的性价比表现出色。

四、适用场景与目标用户

最佳使用场景:

-

企业知识管理:将内部文档、手册、政策转化为可查询的AI助手,确保信息的准确性和一致性

-

行业专业应用:

- 金融:风险评估、合规检查、投资分析

- 医疗:病历分析、诊断辅助、药物信息查询

- 法律:合同审查、案例分析、法规解读

- 制造:技术文档问答、故障诊断、工艺优化

-

客户服务自动化:基于企业产品和服务数据训练的高精度客服AI,显著减少错误回答

-

软件开发辅助:针对特定代码库和技术栈训练的编程助手,提供精准的代码建议和错误修复

适用人群画像:

- 企业AI团队:希望快速构建专业AI能力而无需从零搭建基础设施的公司

- 软件开发团队:需要将AI集成到现有产品中,但缺乏深度机器学习专业知识的开发者

- 数据科学家:希望专注于模型调优和业务逻辑,而非底层基础设施管理的专业人士

- 中大型企业CTO/CIO:寻求在保证数据安全的前提下实现AI转型的技术决策者

不适合的情况:

- 预算极其有限的个人开发者或小型初创公司

- 对通用AI能力已满足需求,无需专业定制的场景

- 缺乏技术团队支撑,无法进行模型部署和维护的传统企业

- 对AI输出精确度要求不高,可接受一定幻觉率的应用场景

五、市场地位与竞品对比

主要竞品分析:

-

vs. Anyscale

- Anyscale专注于Ray生态系统和分布式计算,更适合有ML基础的团队

- Lamini在降低使用门槛和Memory Tuning技术上有明显优势

- Anyscale在大规模训练基础设施方面更为成熟

-

vs. Together AI

- Together AI主要提供模型即服务,缺乏深度定制能力

- Lamini的企业级部署和私有数据训练能力更强

- Together AI在模型种类和即用性方面有优势

-

vs. OpenAI Enterprise

- OpenAI提供强大的通用模型,但定制化能力有限

- Lamini在数据隐私和本地部署方面优势明显

- OpenAI在生态系统成熟度和开发者社区方面领先

差异化优势:

Lamini的核心差异化在于其"Expert AI"理念,专注于将通用AI转化为领域专家。其Memory Tuning技术是目前市场上独有的解决方案,能够在保持模型通用能力的同时实现近乎完美的事实记忆。此外,Lamini是唯一支持AMD GPU的企业LLM平台,为客户提供了更多硬件选择和成本优化空间。

市场表现:

从融资表现来看,Lamini获得了包括Andrew Ng、Andrej Karpathy、Drew Houston等AI领域顶级专家和企业家的投资,显示出强劲的市场信心。其客户群体涵盖Fortune 500企业、顶级AI初创公司和政府机构,证明了平台的企业级可靠性。

在技术创新方面,Lamini发布的"摄影记忆"评估套件和多节点LLM训练技术都代表了行业前沿,其研究团队在LLM scaling laws等核心技术上具有原创性贡献。

六、用户体验评价

界面和操作体验:

Lamini提供了简洁直观的用户界面,支持代码和图形化两种操作方式。开发者可以通过几行Python代码完成复杂的模型训练,也可以通过Web界面进行可视化操作。平台的设计哲学是"让复杂的MLOps变得直观、自动化和可扩展",用户反馈普遍认为上手门槛低,操作流程清晰。

技术支持质量:

Lamini提供多层次的技术支持:

- 详尽的在线文档和教程视频

- 实时的在线支持和邮件响应

- 企业客户享有专属AI工程师支持

- 定期举办的开发者webinar和培训

用户普遍反映技术支持响应迅速,问题解决彻底。CEO Sharon Zhou经常亲自参与技术支持,体现了公司对用户体验的重视。

社区生态:

虽然Lamini相对年轻,但已经建立了活跃的开发者社区。平台在GitHub上开源了数据集生成器和相关工具,获得了开发者的积极响应。公司定期参与AI会议和行业活动,与Hugging Face、AMD等重要合作伙伴建立了紧密的生态关系。

安全隐私:

Lamini在安全和隐私方面表现出色,支持完全本地部署和空气隔离环境,确保企业数据不会离开其安全边界。平台通过了多项企业级安全认证,符合GDPR、SOC 2等合规要求。其"数据在哪里安全存储,LLM就在哪里安全部署"的理念得到了用户的高度认可。

多位企业用户在公开场合表示,Lamini的安全部署能力是他们选择该平台的关键因素,特别是在金融、医疗等对数据安全要求极高的行业。

总结评价

Lamini作为一个专注于企业级LLM训练和部署的平台,在技术创新、产品易用性和市场定位方面都展现出了强劲的竞争力。其独创的Memory Tuning技术有效解决了LLM幻觉问题,95%的准确率提升对企业应用具有重要意义。平台在安全部署、成本控制和技术支持方面的全面表现,使其成为企业AI转型的理想选择。

从市场前景来看,随着企业对AI精确度要求的不断提高,以及对数据安全和模型可控性的重视,Lamini的Expert AI理念将获得更大的市场认可。其与AMD的深度合作也为打破英伟达垄断、降低AI基础设施成本提供了新的可能性。

不过,平台仍面临一些挑战:相对较小的团队规模(约10-35人)可能限制其快速扩张能力;与OpenAI、Google等巨头的竞争将愈发激烈;如何在保持技术领先的同时实现商业化规模还需要时间验证。

推荐指数:★★★★☆

评分依据: Lamini在技术创新性(Memory Tuning)、企业适用性(安全部署)、产品易用性(低门槛开发)方面表现优异,是企业级LLM应用的优质选择。扣除一星主要考虑其相对年轻的生态系统和有限的多语言支持。对于有专业AI需求、重视数据安全的中大型企业,Lamini是值得重点考虑的平台。