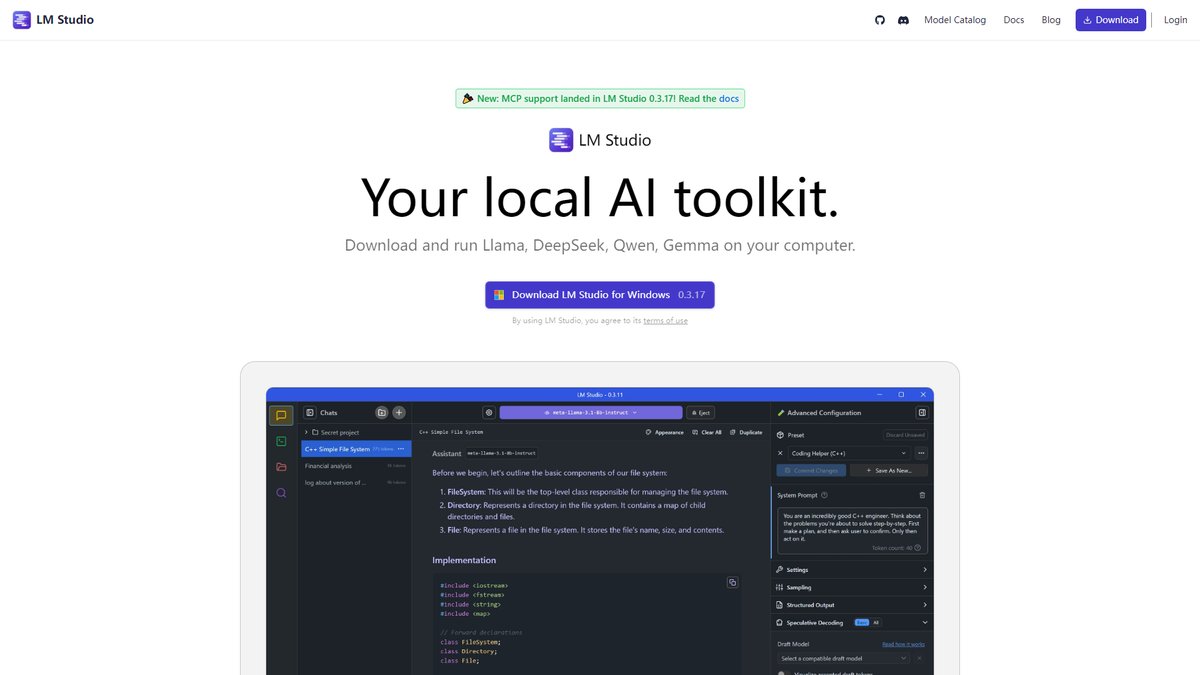

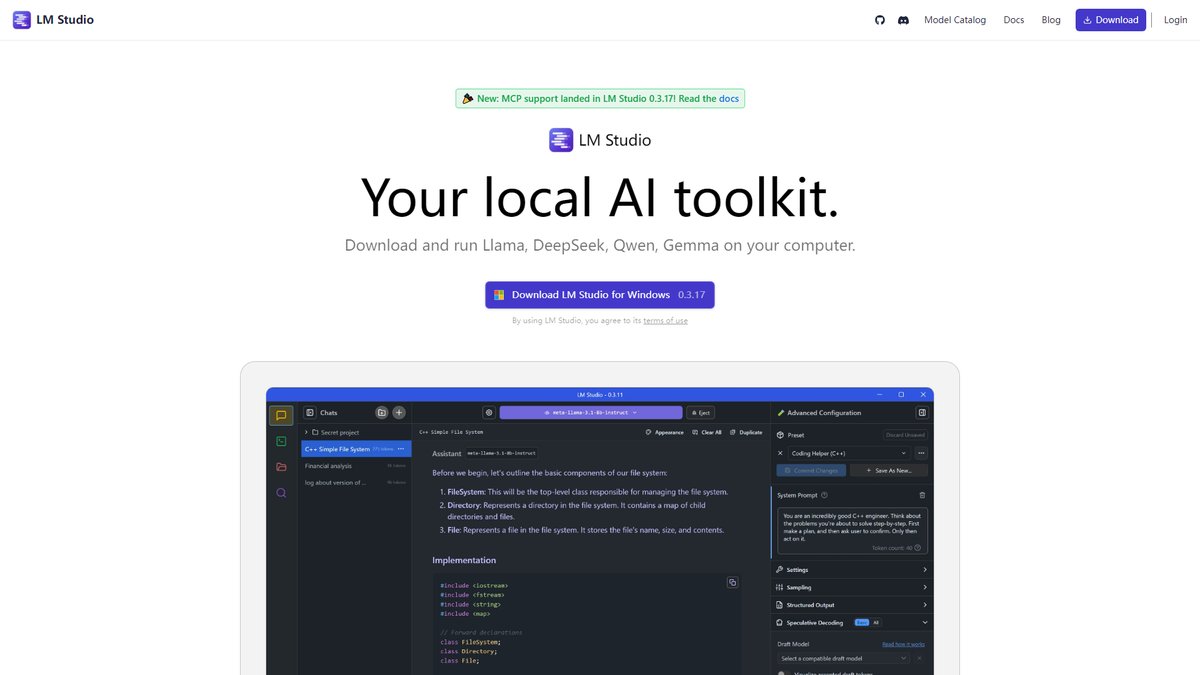

专业级本地大语言模型管理平台,提供一键下载、零配置运行体验,完全保护数据隐私的AI工具

一、工具概览

LM Studio是一款专为本地部署大语言模型而设计的桌面应用程序,它让用户能够在自己的计算机上发现、下载和运行各种开源LLM模型。该工具支持在M1/M2/M3/M4 Mac以及Windows(x86或ARM)和Linux PC(x86)上运行,只要处理器支持AVX2指令集。

基本信息:

- 开发商: LM Studio团队

- 产品定位: 本地LLM管理和运行平台

- 支持平台: Windows、macOS、Linux

- 发布时间: 2024年5月首次发布

- 当前版本: 0.3.17(截至2025年1月)

LM Studio的核心价值在于将原本复杂的本地LLM部署过程简化为几次点击操作。与传统的云端AI服务不同,LM Studio确保用户数据完全本地化处理,无需担心隐私泄露问题。该工具特别适合对数据隐私有严格要求的个人用户、研究人员和企业。

从技术架构角度来看,LM Studio基于两个主要推理引擎:llama.cpp用于跨平台兼容性,MLX专门针对Apple Silicon芯片优化。这种双引擎设计确保了在不同硬件平台上的最佳性能表现。

二、核心功能解析

模型发现与管理

LM Studio的模型管理系统直接集成Hugging Face生态,用户可以运行任何兼容的大语言模型,支持GGUF(llama.cpp)格式和MLX格式(仅Mac)。模型库涵盖了主流的开源模型,包括Llama、Mistral、DeepSeek、Qwen、Phi等系列。

模型搜索功能智能化程度较高,LM Studio的搜索功能包含"兼容性猜测",尝试确定模型是否适合用户的GPU显存。这一功能对新手用户特别友好,避免了下载不兼容模型的资源浪费。

聊天交互界面

内置的聊天界面是LM Studio的亮点功能之一。用户界面简洁直观,支持实时对话,并且可以自定义系统提示词来调整AI的行为模式。LM Studio 0.3.0引入了多种主题选择:深色、浅色、棕褐色,并支持根据系统设置自动切换。

聊天功能的高级特性包括:

- 实时token生成速度显示

- 多种输出格式(纯文本、Markdown、等宽字体)

- 对话导出功能(JSON、文本、格式化提示等)

- 温度、上下文长度等参数调节

RAG文档处理

LM Studio 0.3.0内置了简化版RAG(检索增强生成)功能,允许用户上传个人文档(PDF、DOCX、TXT、CSV),一次最多5个文件,总大小不超过30MB。这一功能让用户可以基于私有文档进行对话,实现个性化的知识库问答。

本地API服务器

LM Studio提供OpenAI兼容的REST API功能,用户可以通过开发者选项卡启动本地服务器,默认运行在http://localhost:1234。这一特性使得LM Studio能够无缝集成到现有的AI应用开发工作流中,开发者可以使用熟悉的OpenAI API调用方式。

三、商业模式与定价

LM Studio采用独特的"个人免费+企业付费"模式。LM Studio目前遵循完全免费和开放访问模式,没有订阅费用、使用费或隐藏计费。从下载模型到启动本地推理服务器的所有功能都免费提供。

个人用户:

- 完全免费使用

- 无功能限制

- 无使用时长限制

- 支持所有基础功能

企业用户:

企业需要填写LM Studio @ Work申请表格获取商业许可,企业版本提供:

- SAML/OIDC身份提供商集成(Okta、Google Workspace等)

- 企业级部署支持

- 专业技术支持

- 自定义配置选项

LM Studio是个人实验免费的,但要求企业联系购买商业许可证。这种定价策略既保证了个人用户的可访问性,也为商业化发展提供了可持续的收入模式。

值得注意的是,虽然LM Studio GUI应用不开源,但其CLI工具lms、核心SDK和MLX推理引擎都采用MIT许可证开源,这在一定程度上缓解了用户对闭源软件的担忧。

四、适用场景与目标用户

最佳使用场景

隐私敏感场景: LM Studio最大的优势在于完全本地化处理,适合处理包含敏感信息的文档和对话。法律、医疗、金融等行业的专业人士可以在不泄露客户信息的前提下使用AI助手。

离线工作环境: LM Studio在正常操作期间不需要活跃的互联网连接,这使其成为网络受限环境或需要离线工作场景的理想选择。

AI学习和实验: 对于AI研究人员和学习者,LM Studio提供了一个低门槛的平台来实验不同的模型和参数配置,无需复杂的命令行操作。

原型开发: 如果你正在寻找开发AI应用程序,并且你有Mac或Linux机器,Ollama很棒,因为它很容易设置、易于使用且速度快,但LM Studio在Windows平台上提供了更好的GUI体验。

目标用户画像

技术爱好者和早期采用者: 对新技术敏感,希望在本地体验最新的AI模型,但不想处理复杂的技术配置。

隐私意识用户: 对数据安全有高度关注,不愿意将敏感信息上传到云端服务的个人用户和小团队。

教育工作者和学生: 需要在教学或学习过程中演示和实验AI模型,但受到预算或网络限制的用户。

中小企业: 希望集成AI功能但担心云服务成本和数据安全的企业用户。

不适合的情况

大规模生产部署: LM Studio主要面向个人和小团队使用,不适合需要高并发、高可用性的生产环境。

资源受限设备: 至少需要16GB RAM和支持AVX2的处理器,对于低配置设备不够友好。

需要最新模型: 云端服务通常能更快获得最新的商业模型,而本地部署主要限于开源模型。

五、市场地位与竞品对比

主要竞品分析

LM Studio vs Ollama:

LM Studio优先考虑易用性,具有适合初学者的精美GUI,而Ollama通过其开发者友好的命令行界面和REST API提供更大的灵活性和控制。Ollama在技术用户中更受欢迎,但LM Studio对非技术用户更友好。

LM Studio vs GPT4All:

GPT4All在开箱即用的文档聊天功能方面表现最佳,也是最容易设置的。然而,LM Studio处理用户提供的任何文档都能正确处理(或显示可理解的错误),还能无问题地处理上传的图像。

LM Studio vs Jan:

Jan作为"LM Studio的开源替代品"推出,但在成熟度和稳定性方面仍有差距。Jan在文档上传方面存在问题,文档解释功能完全无法工作。

差异化优势

用户体验优势: LM Studio在界面设计和用户交互方面明显领先于大多数竞品。LM Studio的界面最现代化,虽然不是开源的。

技术整合能力: 双引擎架构(llama.cpp + MLX)确保了跨平台的优秀性能,特别是在Apple Silicon上的优化表现突出。

生态系统集成: 与Hugging Face的深度集成提供了最广泛的模型选择,同时保持了良好的用户体验。

市场表现

LM Studio是这个列表中唯一不开源的项目,但它仍然是希望在本地机器上管理和与LLM交互的用户的有用工具。尽管不开源,LM Studio凭借其出色的用户体验和稳定性在本地LLM工具市场中占据了重要地位。

社区反馈普遍积极,X(Twitter)上的用户称其为"运行本地LLM的最简单方法",Reddit的r/LocalLLaMA社区也认为它对初学者友好。

六、用户体验评价

界面和操作体验

LM Studio的界面设计现代且直观,采用了清晰的信息层次结构。LM Studio 0.3.0自动配置所有基于运行硬件的参数。对于那些想要深入了解并自己配置的用户,LM Studio提供了更多可自定义选项。

新手友好度极高,大多数用户能在10分钟内完成第一次模型对话。LM Studio的安装过程不到五分钟,远低于竞品的学习曲线。

性能表现

性能方面存在一些用户体验差异。LM Studio在底部显示token生成速度为3.57 tok/s,但在任何token输出之前存在明显的处理时间,这使得整体体验感觉较慢。这个问题在处理大型模型时更为明显。

技术支持质量

LM Studio提供了完善的文档系统和活跃的Discord社区。用户可以通过官方Discord服务器获得讨论和社区支持。文档质量较高,涵盖了从基础使用到高级配置的各个方面。

社区生态

虽然LM Studio本身不开源,但围绕其形成的用户社区相当活跃。用户分享模型推荐、配置技巧和使用案例,形成了良性的知识交流环境。

安全隐私

LM Studio的应用不收集数据或监控用户行为,数据保持在用户机器上的本地。这一点得到了用户的高度认可,特别是在数据隐私意识日益提高的今天。

隐私保护是LM Studio的核心卖点之一,所有模型推理和数据处理都在本地完成,确保敏感信息不会离开用户设备。

总结评价

LM Studio作为本地LLM部署工具的佼佼者,成功地在易用性和功能丰富度之间找到了平衡点。其最大的价值在于大幅降低了本地AI部署的技术门槛,让非技术用户也能轻松享受到大语言模型的强大能力。

核心优势:

- 出色的用户体验和现代化界面设计

- 完全免费的个人使用政策

- 强大的隐私保护机制

- 与Hugging Face生态的深度整合

- 跨平台兼容性和性能优化

主要局限:

- 闭源性质可能限制某些用户的接受度

- 对硬件要求较高,特别是内存需求

- 处理大型模型时的初始加载时间较长

- 缺乏企业级的高级功能

推荐指数:★★★★☆

LM Studio特别适合希望在本地运行AI模型的个人用户、研究人员和小团队。其友好的用户界面和稳定的性能表现使其成为本地LLM工具的首选之一。尽管存在一些局限性,但在当前的市场环境下,LM Studio仍然是最值得推荐的本地AI部署方案之一。

随着本地AI技术的不断发展和硬件性能的提升,LM Studio有望继续扩大其市场影响力,成为连接普通用户与高级AI能力的重要桥梁。