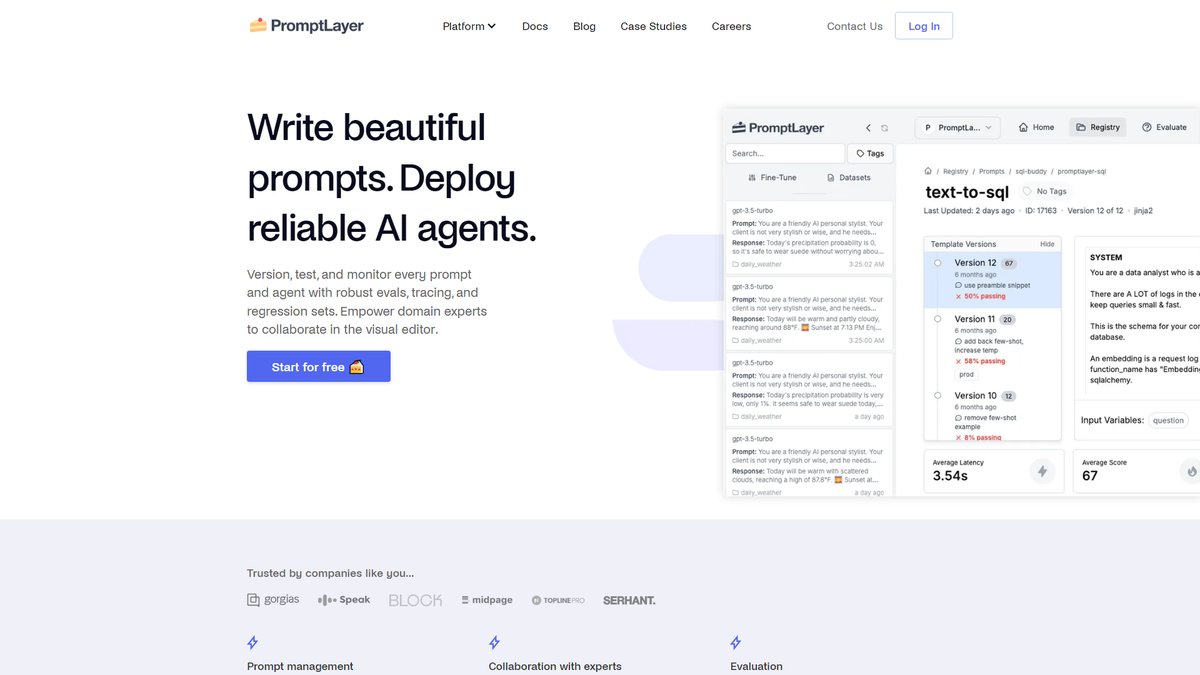

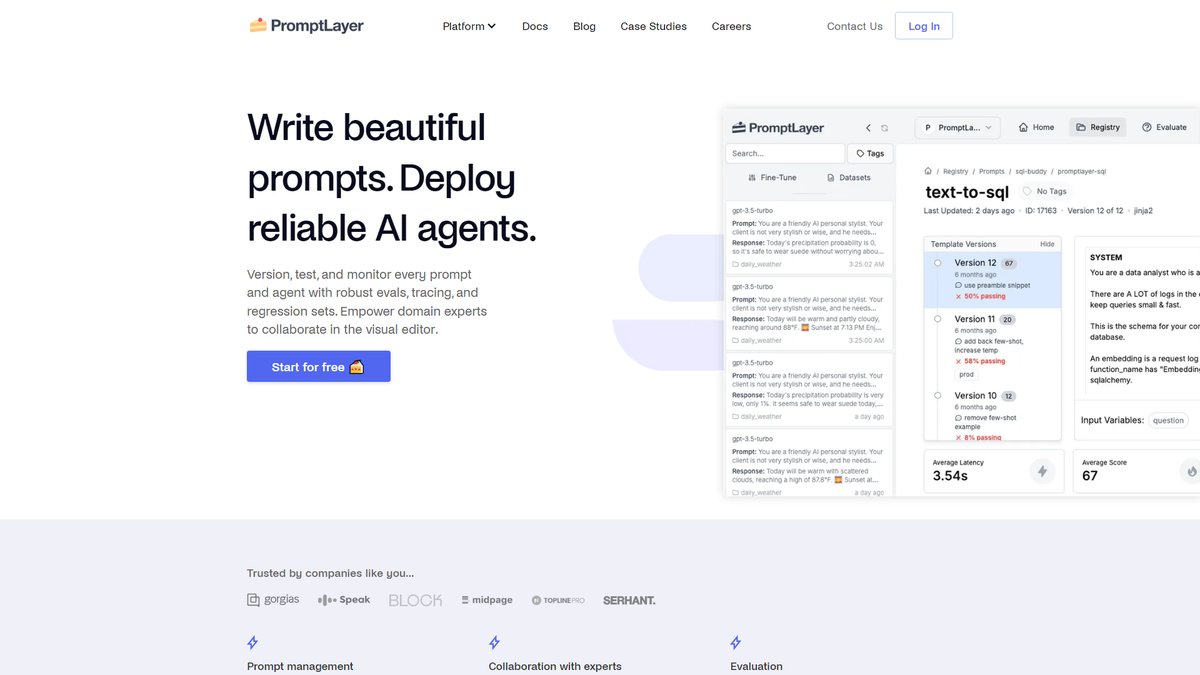

专为prompt工程师打造的可视化prompt管理平台,通过强大的版本控制、A/B测试和协作功能,让非技术团队也能独立迭代AI功能

一、工具概览

PromptLayer是一个专门为prompt工程师设计的综合性平台,旨在简化大语言模型(LLM)应用的prompt管理、测试、部署和监控全流程。该平台成立于2021年,总部位于纽约,通过可视化的Prompt Registry让用户能够创建、版本化、测试和协作管理prompt模板。

与传统将prompt分散在代码库中的做法不同,PromptLayer将prompt作为独立资源进行集中管理。平台的核心理念是”让领域专家成为最佳的prompt工程师”,因为构建优秀AI的关键在于理解用户需求。这一理念驱动着PromptLayer为技术和非技术团队提供无障碍的协作环境。

PromptLayer支持多种主流LLM模型,虽然其prompt模板是模型无关的,但平台主要专注于支持OpenAI模型,使用其他主要模型可能需要自定义变通方案和集成。该工具可通过Python、JavaScript或REST API与现有LLM项目和LangChain等工具集成。

二、核心功能深度解析

Prompt Registry:可视化管理中心

Prompt Registry是PromptLayer的核心功能,提供了一个可视化的hub来创建、版本化、测试和协作管理prompt模板。用户可以通过直观的界面编辑prompt,无需编程知识。该功能支持:

- 版本控制:用户可以通过dashboard以可视化方式编辑和部署prompt版本,无需编码

- 变更管理:支持评论、写笔记、对比版本差异和回滚变更

- 部署机制:可以交互式地为生产环境和开发环境发布新prompt

A/B测试与评估框架

PromptLayer内置了强大的A/B测试功能,包括用于A/B测试prompt模板和管理流量分割的专门功能,这是许多竞品所缺失的特性。评估体系包括:

- 历史回测:查看新prompt版本在历史数据上的表现

- 回归测试:每次prompt更新时触发评估运行

- 模型对比:针对不同模型和参数测试prompt

- 批量任务:针对一批测试输入运行prompt流水线

监控与分析

平台提供全面的使用监控功能,帮助用户理解LLM应用的使用情况、使用者和使用频率,无需在Mixpanel或Datadog之间跳转。监控功能涵盖:

- 成本和延迟统计:查看LLM使用的高级统计信息

- 延迟趋势:了解随时间、功能和模型的延迟趋势

- 错误追踪:快速找到给定用户的执行日志

协作与权限管理

PromptLayer的一大亮点是让非技术团队能够独立参与prompt工程。通过将prompt从代码中移出并通过CMS提供服务,让产品经理或内容写作者等领域专家能够通过PromptLayer dashboard编辑和测试prompt版本。

三、商业模式与定价

PromptLayer采用分层订阅模式,免费计划为大多数用户提供充足资源,让个人和小项目能够免费利用PromptLayer的核心功能。

免费版本

免费套餐包括7天日志保留和每月最多5,000个请求,适合个人开发者和小型项目进行功能验证。

Pro版本

Pro计划专为小团队设计,费用为每用户每月50美元,包括无限日志保留、每月最多100,000个请求、高级功能和协作工具。相比竞品LangSmith的39美元定价略高,但提供了更丰富的可视化功能。

企业版本

针对大型组织提供自定义定价方案,包含企业级安全、合规性管理和自托管选项。

四、适用场景与目标用户

最佳使用场景

- 跨团队协作项目:需要让非技术利益相关者参与prompt迭代的团队

- 频繁prompt调优:用户评价显示”我们每天都要迭代prompt几十次,没有PromptLayer就不可能安全地做到这一点”

- AI产品快速迭代:案例显示Speak公司”将数月的课程开发工作压缩到一周内,并在10个新市场推出”

- 大规模prompt管理:ParentLab在6个月内进行了700次prompt修订,节省400多个工程小时

目标用户群体

技术团队:

- ML工程师和AI开发者

- 需要LLM observability的开发团队

- 构建AI代理和复杂工作流的团队

非技术团队: PromptLayer的设计面向更广泛的受众,包括ML工程师、产品团队,甚至参与prompt创建的非技术内容写作者或领域专家

- 产品经理和内容团队

- 教育、医疗、法律等领域的专业人士

- 营销和客户支持团队

不适合的情况

- 只需要基础prompt测试的个人项目

- 预算极其有限的小型团队

- 对自托管有强烈要求但预算不足的组织

- 深度依赖LangChain生态且不需要可视化界面的纯技术团队

五、市场地位与竞品对比

主要竞争对手

LangSmith: LangSmith专注于提供深度可观察性、调试和严格评估,与开发者和数据科学社区联系紧密,特别是使用LangChain的用户。定价为每用户每月39美元,比PromptLayer便宜11美元。

优势对比:

- PromptLayer提供专门的可视化Agent Builder功能来创建多步骤LLM工作流,LangSmith没有直接等效功能

- PromptLayer包含内置的A/B测试prompt模板功能,LangSmith没有明确列出此专门功能

- PromptLayer通过LiteLLM和直接Hugging Face支持等集成强调灵活性,而LangSmith提供与LangChain和LangGraph生态系统的深度原生集成

Parea: 专注于prompt实验和评估的平台,提供prompt版本间的并排比较、CSV导入测试用例、自定义评估指标定义等功能。

Langfuse: Langfuse是LangSmith的开源替代方案,可以免费自托管,而LangSmith需要购买才能自托管。

差异化优势

- 可视化优先设计:PromptLayer重度依赖可视化界面,包括无代码prompt编辑器和拖拽式Agent Builder

- 非技术友好:在让非技术团队参与prompt工程方面具有显著优势

- 模型灵活性:支持多种LLM提供商,不绑定特定框架

- 企业就绪:提供完整的协作和合规功能

市场表现

PromptLayer已被超过1000名工程师信任,用于版本控制prompt和监控API使用。客户案例包括Gorgias、Speak、ParentLab、Ellipsis等知名公司,覆盖客户支持、教育、医疗健康等多个垂直领域。

六、用户体验评价

界面和操作体验

用户反馈显示PromptLayer在易用性方面表现出色。Ellipsis的用户表示”如果我在桌前看到某人的工作流出现问题,只需要3到4次点击就能解决。我打开PromptLayer,按工作流ID过滤,就能找到问题。信息密度意味着我的生产力时间非常好”。

学习成本

平台的可视化设计大幅降低了学习门槛。Speak的用户评价:”使用PromptLayer,我在一周内完成了数月的工作量。它让我能够大幅扩展内容创建流程,从课程大纲直接产生用户可以立即参与的应用就绪内容”。

技术支持质量

PromptLayer提供在线支持,且在GitHub和官方文档方面维护良好。该工具可以与现有LLM项目和LangChain等工具集成,支持Python和JavaScript。

社区生态

虽然PromptLayer不是开源项目,但建立了活跃的用户社区。官方表示”我们正在为真正的AI构建者:prompt工程师建立一个社区。他们有各种形式和规模。律师、医生、教育工作者,甚至软件工程师”。

总结评价

PromptLayer作为专业的prompt工程平台,在可视化管理、团队协作和非技术用户友好性方面表现出色。其核心价值在于降低prompt工程的技术门槛,让领域专家能够直接参与AI产品的迭代优化。

主要优势:

- 强大的可视化prompt管理能力

- 内置A/B测试和评估框架

- 优秀的跨团队协作功能

- 支持多种LLM模型和框架集成

- 丰富的监控和分析功能

局限性:

- 定价相对竞品较高

- 无自托管免费选项

- 主要优化OpenAI模型支持

对于需要频繁进行prompt迭代、重视团队协作、希望让非技术团队参与AI开发的组织,PromptLayer是一个值得考虑的优质选择。特别适合产品导向的AI团队和需要快速迭代的创业公司。

推荐指数:★★★★☆

评分依据:功能完整性强、用户体验优秀、市场认可度高,但定价略高且缺乏开源选项。